تعمل OpenAI على نشر نتائج تقييمات سلامة نماذج الذكاء الاصطناعي الداخلية بشكل أكثر انتظامًا في ما تعتبره محاولة لزيادة الشفافية.

في يوم الأربعاء، أطلقت OpenAI مركز تقييمات السلامة، وهو صفحة ويب تظهر كيف تُقيم نماذج الشركة وفقًا لاختبارات مختلفة لتوليد المحتوى الضار، وكسر الحماية، والهلاوس. تقول OpenAI إنها ستستخدم المركز لمشاركة المقاييس بشكل “مستمر”، وأنها تعتزم تحديث المركز مع “تحديثات رئيسية للنماذج” في المستقبل.

“بينما تتطور علوم تقييم الذكاء الاصطناعي، نهدف إلى مشاركة تقدمنا في تطوير طرق أكثر قابلية للتوسع لقياس قدرة النموذج وسلامته،” كتبت OpenAI في منشور مدونة. “من خلال مشاركة مجموعة من نتائج تقييم السلامة لدينا هنا، نأمل أن يسهل ذلك فهم أداء سلامة أنظمة OpenAI بمرور الوقت، وأن يدعم أيضًا جهود المجتمع لزيادة الشفافية عبر هذا المجال.”

تقول OpenAI إنها قد تضيف تقييمات إضافية إلى المركز مع مرور الوقت.

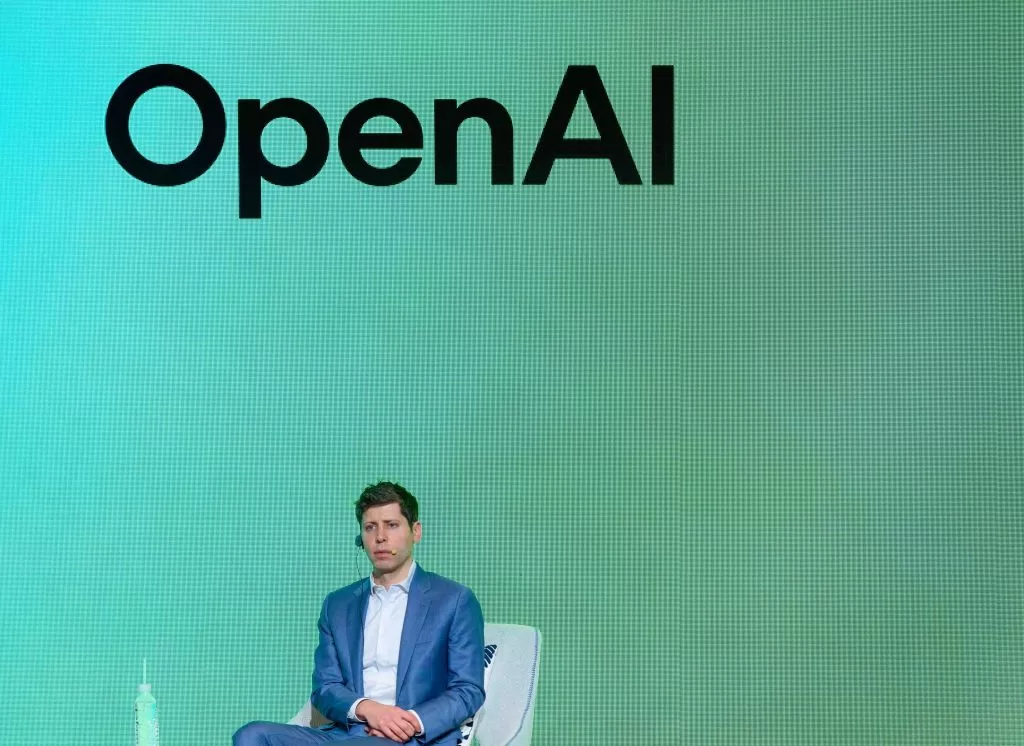

في الأشهر الأخيرة، أثارت OpenAI غضب بعض خبراء الأخلاقيات لتسرعها في اختبار السلامة لبعض النماذج الرئيسية وفشلها في إصدار تقارير فنية لأخرى. كما يتهم الرئيس التنفيذي للشركة، سام ألتمان، أيضًا بتضليل مسؤولي OpenAI بشأن مراجعات السلامة للنماذج قبل إقالته القصيرة في نوفمبر 2023.

في أواخر الشهر الماضي، أُجبرت OpenAI على التراجع عن تحديث النموذج الافتراضي الذي يدعم ChatGPT، GPT-4o، بعد أن بدأ المستخدمون في الإبلاغ عن أنه كان يستجيب بطريقة مفرطة في المديح والاتفاق. امتلأت منصة X بلقطات شاشة لـ ChatGPT وهو يثني على جميع أنواع القرارات والأفكار المثيرة للمشاكل والخطيرة.

قالت OpenAI إنها ستنفذ العديد من الإصلاحات والتغييرات لمنع حدوث مثل هذه الحوادث في المستقبل، بما في ذلك تقديم “مرحلة ألفا” اختيارية لبعض النماذج التي ستسمح لبعض مستخدمي ChatGPT باختبار النماذج وتقديم ملاحظات قبل الإطلاق.